0. 前沿

MIT 18.06 二刷成就达成,bing ~

果然好的课程再看多少遍都有新发现

这个主要是把老爷子讲的内容拆开重新归纳整理记录一下

老爷子讲的时候为了清楚会把来龙去脉讲的很清楚,但是就需要看完了之后把知识点拆散再重新组装整理,方便以后使用记忆

1. 矩阵的LU分解

1.1 Motivation: 求解线性方程组

$$ \begin{cases} x+ &2y+ &z &=2 \\ 3x+ &8y+ &z &=12 \\ &4y+ &z &=2 \end{cases} \rightarrow Ax=b \qquad A=\begin{bmatrix} 1 &2 &1 \\ 3 &8 &1 \\ 0 &4 &1 \end{bmatrix} $$

1.2 消元法与回代

1.2.1 消元

$$ A= \begin{bmatrix} 1 &2 &1 \\ 3 &8 &1 \\ 0 &4 &1 \end{bmatrix} \stackrel{(2,1)}{\rightarrow} \begin{bmatrix} 1 &2 &1 \\ 0 &2 &-2 \\ 0 &4 &1 \end{bmatrix} \stackrel{(3,2)}{\rightarrow} \begin{bmatrix} 1 &2 &1 \\ 0 &2 &-2 \\ 0 &0 &5 \end{bmatrix} = U$$

箭头上方表示想要消去的元素的位置

这里消元的目的就是为了从$A$得到上三角矩阵$U$。而经过整个变换之后,因为是行变换,所以对解$x$并没有变

1.2.2 回代

增广矩阵:把右侧向量$b$带入$A$,引入$b$作为新的一列向量加入到矩阵中,得到增广矩阵,即

$$ [A|b] = \begin{bmatrix} 1 &2 &1 &2 \\ 3 &8 &1 &12 \\ 0 &4 &1 &2 \end{bmatrix} $$

因为对左侧矩阵进行变化的同时,右侧向量也会跟着做同样的变化,所以按照上面的消元法:

$$ \begin{bmatrix} 1 &2 &1 &2 \\ 3 &8 &1 &12\\ 0 &4 &1 &2 \end{bmatrix} \stackrel{(2,1)}{\rightarrow} \begin{bmatrix} 1 &2 &1 &2 \\ 0 &2 &-2 &6 \\ 0 &4 &1 &2 \end{bmatrix} \stackrel{(3,2)}{\rightarrow} \begin{bmatrix} 1 &2 &1 &2 \\ 0 &2 &-2 &6 \\ 0 &0 &5 &-10 \end{bmatrix} \rightarrow c=\begin{bmatrix} 2 \\ 6 \\ -10\end{bmatrix}$$

所以最终方程的形式是这样的:

$$\begin{cases} x+ &2y+ &z &=2 \\ &2y- &2z &=6 \\ & &5z &=-10\end{cases}\rightarrow Ux=c$$

接下来进行回代求解:$z=-2; y=1; x=2$

1.3 消元法的矩阵形式

$$\begin{bmatrix} 1 &2 &1 \\ 3 &8 &1 \\ 0 &4 &1 \end{bmatrix} \stackrel{(2,1)}{\rightarrow} \begin{bmatrix} 1 &2 &1 \\ 0 &2 &-2 \\ 0 &4 &1 \end{bmatrix} \Rightarrow \begin{bmatrix} 1 &0 &0 \\ -3 &1 &0 \\ 0 &0 &1 \end{bmatrix} \begin{bmatrix} 1 &2 &1 \\ 3 &8 &1 \\ 0 &4 &1 \end{bmatrix} = \begin{bmatrix} 1 &2 &1 \\ 0 &2 &-2 \\ 0 &4 &1 \end{bmatrix}$$

对$(2,1)$的消元就变成了一个特定的矩阵: 消元矩阵

$$E_{21} = \begin{bmatrix} 1 &0 &0 \\ -3 &1 &0 \\ 0 &0 &1 \end{bmatrix}$$

初等矩阵 $(E)$:由单位矩阵经过一次初等变换得到的矩阵,消元矩阵的每一行都是对单位阵的一次初等行变换,所以使用 $E$ 表示。

因为是对(2,1)位置上进行消元,所以可以写成$E_{21}$。所以,整个过程使用矩阵形式表达:

$$E_{32}(E_{21}A)=U$$

矩阵乘法满足结合律,所以可以将括号移动,变成一个矩阵,来实现所有的消元任务。但是矩阵乘法不满足交换律,不可轻易调换他们的顺序

$$(E_{32}E_{21})A=U$$

1.4 矩阵的LU分解

考虑三维矩阵,对A进行消元得到U,即

$$E_{32}E_{31}E_{21}A=U$$

可以写成$A=LU$形式,即:

$$A=E_{21}^{-1}E_{31}^{-1}E_{32}^{-1}U$$

其中$U$表示的上三角矩阵,$L$表示的下三角矩阵

$$ \begin{cases} A = LU \\ EA=U \end{cases} $$

下面讨论这两种形式,为什么要变成$A=LU$的形式

对于$A=LU$如果不存在行互换,消元乘数可以直接写进$L$里面

举个例子

$$ E_{32}=\begin{bmatrix} 1 &0 &0 \\ 0 &1 &0 \\ 0 & -5 &1 \end{bmatrix} E_{31} = I \quad E_{21}=\begin{bmatrix} 1 &0 &0 \\ -2 &1 &0 \\ 0 &0 &1 \end{bmatrix} $$

对矩阵进行消元,进行上述消元变化:$E_{21}$和$E_{32}$

$$ E=E_{32}E_{31}E_{21} = \begin{bmatrix} 1 &0 &0 \\ -2 &1 &0 \\ 10 &-5 &1 \end{bmatrix} $$

这种形式下可以看到行1通过行2影响到了行3,在(1,3)位置出现了10

$$ L = E_{21}^{-1}E_{32}^{-1}= \begin{bmatrix} 1 &0 &0 \\ 2 &1 &0 \\ 0 &0 &1 \end{bmatrix} \begin{bmatrix} 1 &0 &0 \\ 0 &1 &0 \\ 0 & 5 &1 \end{bmatrix} = \begin{bmatrix} 1 &0 &0 \\ 2 &1 &0 \\ 0 &5 &1 \end{bmatrix} $$

在这种形势下,2和5不会冲突产生10,也就是消元乘数可以直接写到$L$里

1.5 求解线性方程组

上面所述,针对的是特殊的线性方程组,正好只有一个解,非常容易。

有了前面的铺垫,现在开始针对一般的线性方程组,有多个解;无解的线性方程组进行求解

1.5.1 Ax=0

消元法来求解$Ax=0$,即$A$的零空间

$$ A=\begin{bmatrix} 1 &2 &2 &2 \\ 2 &4 &6 &8 \\ 3 &6 &8 &10 \end{bmatrix} $$

下面通过消元将$Ax=0$变化为$Ux=0$

$$ A=\begin{bmatrix} 1 &2 &2 &2 \\ 2 &4 &6 &8 \\ 3 &6 &8 &10 \end{bmatrix} \rightarrow \begin{bmatrix} 1 &2 &2 &2 \\ 0 &0 &2 &4 \\ 0 &0 &2 &4 \end{bmatrix} \rightarrow \begin{bmatrix} \colorbox{yellow}{\color{red}{1}} &2 &\colorbox{yellow}{2} &2 \\ \colorbox{yellow}{0} &0 &\colorbox{yellow}{\color{red}{2}} &4 \\ \colorbox{yellow}{0} &0 &\colorbox{yellow}{0} &0 \end{bmatrix}=U $$

现在从$Ax=0$变换到了$Ux=0$,因为是行变换,他的解没有 变,也就是零空间没有变

- 阶梯型矩阵 (echelon form):非零元素以一种阶梯形式出现

- 主元 (pivots): 阶梯矩阵中,非零行第一个非零元素就是主元。即 $U$ 中的红色数字

- 秩 (rank): 矩阵主元的个数,记作$r$,

- 主列 (pivot column): 主元所在列,即 $U$ 中黄色背景所在的列

- 自由列 (free column): 非主列的其他列

自由列表示可以任意、自由的分配数值;列2和列4的乘数是任意的,即可以任意的分配$x_{2}$和$x_{4}$。当$x_{2}$和$x_{4}$固定下来,$x_{1}$和$x_{3}$随之固定

$$ x_{2}=1,x_{4}=0 \Rightarrow \begin{bmatrix} -2 \\ 1 \\ 0 \\ 0 \end{bmatrix};x_{2}=0,x_{4}=1 \Rightarrow \begin{bmatrix} 2 \\ 0 \\ -2 \\ 1 \end{bmatrix} $$

所以,$Ax=0$的解就是

$$ c_{1}\begin{bmatrix} 2 \\ 0 \\ -2 \\ 1 \end{bmatrix}+ c_{2}\begin{bmatrix} -2 \\ 1 \\ 0 \\ 0 \end{bmatrix} $$

如果矩阵$A_{m\times n}$的秩$r=2$,表示只有r个方程起作用。他的自由列、自由变量就有$n-r$个,可以采用one-hot形式进行取值,得到特解

可以看到,使用列向量来理解整个矩阵、方程组的求解,理解将会变得非常的顺畅

下面通过对行阶梯形式的$U$进一步的简化,来解释$Ax=0$。

最简行阶梯型矩阵,记为$R$ (Reduced row echelon form):简化行阶梯形式主元上下全是0,主元为1。

$$U=\begin{bmatrix} 1 & 2 & 2 & 2 \\ 0 & 0 & 2 & 4 \\ 0 & 0 & 0 & 0 \end{bmatrix} \rightarrow \begin{bmatrix} 1 & 2 & 0 & -2 \\ 0 & 0 & 1 & 2 \\ 0 & 0 & 0 & 0 \end{bmatrix}=R$$

简化行阶梯形式$R$中包含了这些信息:

$$ R=\begin{bmatrix} \colorbox{yellow}{1} & 2 & \colorbox{yellow}{0} & -2 \\ \colorbox{yellow}{0} & 0 & \colorbox{yellow}{1} & 2 \\ 0 & 0 & 0 & 0 \end{bmatrix} \stackrel{col2\iff col3}{\longrightarrow} \begin{array}{l} \begin{bmatrix} \colorbox{yellow}{1} & \colorbox{yellow}{0} &\colorbox{pink}{2} & \colorbox{pink}{-2} \\ \colorbox{yellow}{0} & \colorbox{yellow}{1} &\colorbox{pink}{0} & \colorbox{pink}{2} \\ \colorbox{orange}{0} & \colorbox{orange}{0} &\colorbox{orange}{0} &\colorbox{orange}{0} \end{bmatrix}\\ \quad c_{1} \quad c_{3} \quad c_{2} \quad c_{4} \end{array} \rightarrow \begin{bmatrix} \colorbox{yellow}{I} \colorbox{pink}{F} \\ \colorbox{orange}{0\quad 0} \end{bmatrix} $$

其中$I_{r\times r}$,自由列$F_{r\times n-r}$

在经过列变换后,我们再求$Rx=0$的解

构造零空间矩阵:他的各列由特解组成,记为$N$,即满足$RN=0$

那么通过上面列变换之后的简化行阶梯形式,我们可以很容易得到

$$N=\begin{bmatrix} -F \\ I\end{bmatrix}=\begin{bmatrix} -2 & 2 \\ 0 & -2 \\ 1 &0 \\ 0 &1\end{bmatrix}$$

再把相应的行2和行3调换回去就可以了,就得到了之前得到的特解

1.5.2 Ax=b

$$ A=\begin{bmatrix} 1 &2 &2 &2 \\ 2 &4 &6 &8 \\ 3 &6 &8 &10 \end{bmatrix} \Rightarrow \begin{cases} x_{1} +&2x_{2}+&2x_{3}+&2x_{4} = b_{1} \\ 2x_{1}+&4x_{2}+&6x_{3}+&8x_{4} = b_{2} \\ 3x_{1}+&6x_{2}+&8x_{3}+&10x_{4} = b_{3} \end{cases} $$

首先和之前回代中做的一样,考虑$Ax=b$的增广矩阵$[A|b]$:

$$ [A|b] = \begin{bmatrix} \begin{array}{cccc|c} 1 &2 &2 &2 &b_{1} \\ 2 &4 &6 &8 &b_{2} \\ 3 &6 &8 &10 &b_{3} \end{array} \end{bmatrix} $$

同上进行消元

$$ \begin{bmatrix} \begin{array}{cccc|c} 1 &2 &2 &2 &b_{1} \\ 0 &0 &2 &4 &b_{2}-2b_{1} \\ 0 &0 &0 &0 &b_{3}-b_{2}-b_{1} \end{array} \end{bmatrix} $$

与$Ax=0$不同,$Ax=b$有可能不存在解,所以需要讨论他的可解性

a) Ax=b 不可解

如果$A$各行的线性组合得到零行,那么$b$中元素的同样组合必然也是零,就像$b_{3}-b_{2}-b_{1}$。所以有解的条件就是$b_{3}-b_{2}-b_{1}=0$。

$Ax=b$有解,当且仅当$b$属于$A$的列空间时

b) Ax=b 可解

当$Ax=b$可解是,我们就要求$Ax=b$的所有解

因为我们之前知道了怎么求$Ax=0$,所以这里可以把$Ax=b$化成$Ax_{n}+Ax_{p}=b$,其中$Ax_{n}=0$。$x_{p}$称为$Ax=b$的特解

第一步只求一个特定的解,即特解(particular solution)

其中一个方法就是,把所有的自由变量设为0,求出$Ax=b$的主变量

按照上面进行举例: $x_{2}=0, x_{4}=0$可以得到

$$\begin{cases} x_{1} +2x_{3} =1 \\ 2x_{3}=3 \end{cases} $$

可得:$x_{1}=-2, \quad x_{3}=\frac{3}{2}$,特解向量为$x_{p}=\begin{bmatrix}-2 \\ 0 \\ \frac{3}{2} \\ 0 \end{bmatrix}$

第二步,求解$A$的零空间$x_{n}$

最终的解就是特解加上零空间中的任意向量$x=x_{p}+x_{n}$

因为$Ax_{p}=b$,$Ax_{n}=0$

c) 使用秩来讨论Ax=b解的数量

矩阵的秩决定了方程组解的数目

列满秩 $(r=n<m)$

每一列都有主元:n个,没有自由变量。

$Ax=0$:这个时候$A$的零空间只有零向量$N(A) = \{ 0\}$

$Ax=b$: 如果有解,只存在一个解,就是特解,即$x=x_{p}$

行满秩 $(r=m<n)$

变量比方程多的情况

有$m$个主元,自由变量为$n-r$个。这个时候通过消元法我们可知不会出现零行,所以对于任意的$b$,$Ax=b$都有解

举个例子,有点不好理解

$$A=\begin{bmatrix} 1 &2 &6 &5 \\ 3 &1 &1 &1\end{bmatrix}$$

矩阵的秩是2,得到的简化阶梯型:

$$R=\begin{bmatrix} 1 &0 &\_ &\_ \\ 0 &1 &\_ &\_ \end{bmatrix}$$

$R$中没有零行,左边是单位阵,右边就是自由变量组成的矩阵$F$,可以任意设定

满秩 $(r=m=n)$

这种矩阵肯定是方阵,他是可逆矩阵,简化阶梯型$R=I$,零空间只有0向量,$Ax=b$有且只有唯一解

2. 矩阵的正交

正交即垂直,90°

2.1 正交向量

正交向量(orthogonal vectors): 在n为空间中,这些向量的夹角是90° (垂直的另一种说法)。即 $x^{T}y=0$

2.2 正交子空间

正交子空间(orthogonal subspace): 子空间$S$和子空间$T$正交,表示$S$中的每个向量都和$T$中的每个向量正交

行空间正交于零空间 $\because Ax=0$,$x$与$A$中的所有行都正交,同时垂直于他们的线性组合(即行空间)

他们两个是$\mathbb{R}^{n}$空间的正交补(orthogonal complements) [补集]

同理,列空间正交于左零空间

2.3 正交基

标准正交基(orthonormal vector): $q_{1},q_{2},\cdots,q_{n}$,任意的$q$都和其他$q$正交,并且因为是“标准”的,所以他们的长度是1,即满足下面的条件

$$ q_{i}^{T}q_{j} = \begin{cases} 1, \text{if } i = j \\ 0, \text{if } i \quad!= j \end{cases} $$

如何求标准正交基:格拉姆-施密特正交化法 (Gram-Schmidt)

逐个向量减去之前向量的分量(即之前向量在这个向量空间上的投影)

对于两个线性无关向量 $a$ 和 $b$,标准正交化的向量 $q_{1}$ 和 $q_{2}$

$$a’ = a;\qquad b’=b-Pa’=b-\frac{a’^{T}b}{a’^{T}a’}a’$$

$$q_{1} = \frac{a’}{||a’||};\qquad q_{2} = \frac{b’}{||b’||}$$

2.4 正交矩阵

标准正交矩阵(方阵):由标准正交基构成的矩阵 $Q=\begin{bmatrix} q_{1},q_{2},\cdots,q_{n}\end{bmatrix}$

性质: $Q^{T} = Q^{-1}$,但是$Q$必须是方阵

举几个标准正交基的好处:

投影

$Q$是标准正交基,现在要将向量投影到他的列空间中,投影矩阵:

$$P = Q(Q^{T}Q)^{-1}Q^{T}= QQ^{T}$$

当$Q$是方阵时,$Q$的列空间就是整个空间,所以投影矩阵是$I$;如果不是方阵,那么结果就是上述这个

最小二乘法

$$A^{T}A\hat{x} = A^{T}b \rightarrow Q^{T}Q\hat{x} = Q^{T}b \rightarrow \hat{x} = Q^{T}b$$

2.5 投影

2.5.1 一维投影

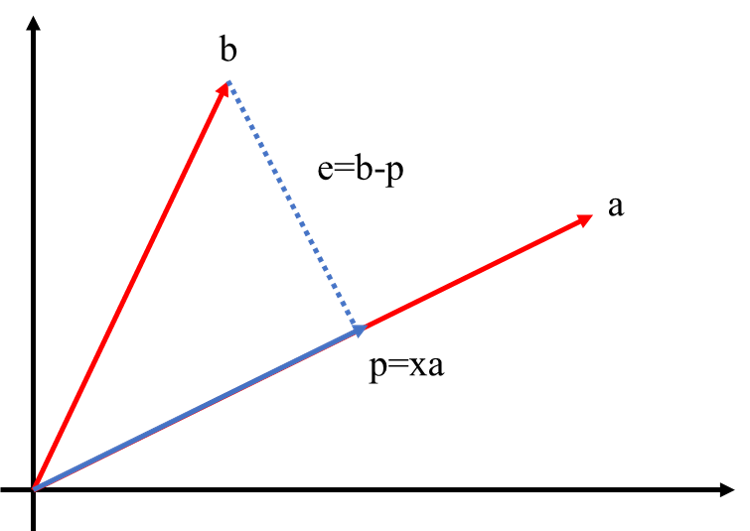

如上图所示,$a$是其所在列空间(直线)中的一个基。现在期望找到$b$在$a$的列空间上最相似的一个向量,即投影$p$。

$p$是$a$的$x$倍($x$为标量),可表示为$p=xa$。想要知道$b$在$a$的列空间上投影,关键就是知道这个$x$。

$p$和$b$的误差表示为$e=b-p=b-xa$。因为误差$e$和$p$垂正交,所以有:

$$a^{T}(b-xa) = 0$$

得到:

$$x=\frac{a^{T}b}{a^{T}a}$$

这个怎么记呢?$x^{T}x$是一个数,然后$b\rightarrow a$的投影,就是$b$是分母,$a$是分子

最终,$b$ 在 $a$ 的列空间上的 投影 就是

$$p=a\frac{a^{T}b}{a^{T}a}$$

其中,帮助$b$投影到$a$的列空间上的矩阵称为投影矩阵 ($P$),在一维情况下表达为:

$$p=Pb, \qquad P_{n\times n} = \frac{aa^{T}}{a^{T}a}$$

2.5.2 高维投影

同一维情况,推导一下如何得到高维投影

现在有一个向量 $b$ 想要投影到 $A$ 的列空间 $C(A)$ 上,得到投影向量 $p$

令 $A$ 的列空间中两个基向量为 $a_{1}, a_{2}$。那么投影向量的表达为: $p = \hat{x_{1}}a_{1} + \hat{x_{2}}a_{2} = A\hat{x}$。同一维中的推理,需要通过垂直来辅助:

$$e = (b-p) = (b-A\hat{x}) \quad \bot \quad C(A)$$

$$ \therefore \begin{cases} a_{1}^{T}(b-A\hat{x}) = 0 \\ a_{2}^{T}(b-A\hat{x}) = 0 \end{cases} $$

$$\therefore A^{T}(b-A\hat{x})=0$$

$e$ 在 $N(A^{T})$ 的空间中,即 $e\bot C(A)$,殊途同归。最终希望得到的 $\hat{x}$ 如下表达:

$$A^{T}A\hat{x} = A^{T}b$$

下面就是最重要的投影三个公式:

系数 $\hat{x}$:

$$\hat{x} = (A^{T}A)^{-1} A^{T} b$$

投影 $p$:

$$p=A\hat{x}=A(A^{T}A)^{-1} A^{T} b$$

投影矩阵 $P$:

$$P = A(A^{T}A)^{-1} A^{T}$$

如果 $A$ 是一个可逆的方阵,那么他的列空间是整个$n$维空间,那么 $P=I$,相当于我投我自己,就没有用,所以上面是唯一一种形式

2.5.3 投影矩阵

投影矩阵 (projection matrix) $P$:

$$P = A(A^{T}A)^{-1} A^{T}$$

这个矩阵是对称的 $P^{T}=P$:从公式看出来的

投影矩阵的平方还是自己 $P^{2}=P$:即对$Pb$在做一次投影的效果 $PPb$ 也还是 $Pb$

2.5.4 应用:最小二乘

$Ax=b$可能会误解,只能求解最接近这个解的解,所以通过投影$p$来代替$b$,即 $A\hat{x}=p$, $p$ 是 $b$ 在列空间$C(A)$上的投影

$$A\hat{x} = p = A(A^{T}A)^{-1} A^{T} b$$

$$A^{T}A\hat{x} = A^{T}b$$

因为这里的$x$不是原来的$x$,所以加个小帽子表示是近似值

3. 矩阵的特征

3.1 行列式

行列式的目的是为了计算矩阵的特征值

3.1.1 行列式性质

矩阵的 行列式(determinant) 记作 $\det{A}$ 或者 $|A|$

行列式的三个性质定义了行列式是个什么东西:

- $\det{I} = 1$,使得单位矩阵的行列式为1,(定义基准)

- 交换行,行列式的值的符号会相反,(现在知道了置换矩阵的行列式)

- 行列式是一个线性函数,对每一行都成立

$$\begin{vmatrix} ta &tb \\ c &d \end{vmatrix}= t \begin{vmatrix} a &b \\ c &d \end{vmatrix}$$

$$\begin{vmatrix} a+a’ &b+b’ \\ c &d \end{vmatrix}= \begin{vmatrix} a &b \\ c &d \end{vmatrix}+\begin{vmatrix} a’ &b’ \\ c &d \end{vmatrix}$$

从以上三条性质可以推出下面:

两行相等使得行列式等于0 (可以由性质2得到)

从行$k$减去行1的$i$倍,行列式不变(性质3+性质2)

若有一行为0,那么行列式就是0 (性质3,$t=0$)

上三角矩阵的行列式等于对角线元素的乘积

$$\det{U}=\begin{vmatrix} d_{1} & \cdots & \cdots & \cdots \\ & d_{2} & \cdots & \cdots \\ & & \ddots & \vdots \\ \Huge0 & & &d_{n} \\ \end{vmatrix}=d_{1}d_{2}\cdots d_{n}$$因为上三角矩阵$U$和原矩阵$A$之间只经过了性质6的线性变换,所以原矩阵$A$的行列式就等于上三角矩阵$U$的行列式。如果其中一个对角线元素为0,那么将得到全0行,行列式为0

$\det{A}=0$ 当且仅当 $A$ 是奇异矩阵,(不可逆)

两个方阵$A$和$B$的矩阵乘积的行列式等于他们行列式的乘积 $\det{AB}=\det{A}\times\det{B}$。所以可以推导出下面:

$$\det{A^{-1}} = \frac{1}{\det{A}}$$

这个其实也说明,如果没有逆,$det{A}=0$,逆就没有意义

$$\det{A^{2}} = (\det{A})^{2}$$

$$\det{2A} = \det{2I}\det{A} = 2^{n}\det{A}$$

矩阵的行列式等于矩阵转置的行列式

$$\det{A^{T}}=\det{A}$$

从这里其实就可以发现,对于行列式来说,行和列并没有什么区别,都是进行行变换/列变换要改变符号的

3.1.2 行列式公式

代数余子式 (cofactors):$$\text{Cofactor}(a_{ij})=(-1)^{ij}\det(n-1\quad \text{matrix with}\begin{aligned}row_{i} \\ col_{j}\end{aligned} \text{earsed})$$

通过代数余子式,我们可以定义扩展到$n$阶的行列式计算:

$$det\space A = \sum_{i}^{n}a_{1i}C_{1i}$$

3.1.3 行列式应用

计算逆矩阵

$$A^{-1}=\frac{1}{\det(A)}C^{T}$$

其中,$C$是由代数余子式构成的矩阵,$C^{T}$一般称为伴随矩阵

克拉默法则

提供一种代数形式的表达,但不适合计算

求解:$Ax=b$

$$x=A^{-1}b=\frac{1}{\det{A}}C^{T}b$$

其中,$x_{j}=\frac{det(B_{j})}{det(A)}$,$B_{j}$是$A$的第$j$列替换成$b$

计算体积

还是先从简单的来说,比如 $3\times 3$的情况:

有3个向量:$(a_{11}, a_{12}, a_{13}); (a_{21}, a_{22}, a_{23}); (a_{31}, a_{32}, a_{33})$他们在空间中组成了一个“箱子”

这个箱子的体积就等于这几个向量构成的矩阵的行列式的绝对值,即 $|\det A|$,扩展到$n$维同理

3.2 特征值和特征向量

特征值和特征向量还是针对方阵而言的

给定矩阵$A$,作用在向量$x$,($A$就像是一个函数对$x$进行变换然后得到了一个新的向量),得到的新的向量$Ax$与原向量$x$平行,即

$$Ax=\lambda x$$

其中,$\lambda$是一个系数,称为特征值(eigen value),$x$是特征向量(eigen vector),可以表征一个矩阵的特征

3.2.1 求解特征值和特征向量

如何求解特征值和特征向量,即$Ax=\lambda x$

将上式重写成: $(A-\lambda I)x=0$,即如果存在$x$使得这个式子成立,那么$A$进行$\lambda I$的偏移后必须是奇异的

奇异矩阵的行列式为0,所以 $\det(A-\lambda I)=0$,这个方程被称为特征方程/特征值方程

举个例子:$A=\left|\begin{aligned}&3&1 \\ &1&3\end{aligned}\right|$

$\therefore \det(A-\lambda I)=\left|\begin{aligned} &3-\lambda & 1 \\ &1 &3-\lambda \end{aligned}\right|=(3-\lambda)^{2}-1=\lambda^{2}-\color{blue}{6}\color{red}\lambda+\color{green}8$

这里的 $\color{blue}{6}$ 是矩阵$A$的迹, $\color{green}{8}$ 是矩阵A的行列式值,对于二阶行列式有这个性质

$\therefore$ 有两个特征值:$\lambda_{1}=4$ $\lambda_{2}=2$

$\lambda_{1}=4$时,$(A-\lambda I)=\begin{bmatrix}-1 &1 \\ 1 &-1\end{bmatrix}$, $x_{1}=\begin{bmatrix}1 \\1\end{bmatrix}$

$\lambda_{2}=2$时,$(A-\lambda I)=\begin{bmatrix}1 &1 \\ 1 &1\end{bmatrix}$, $x_{2}=\begin{bmatrix}-1 \\1\end{bmatrix}$

出现比较糟糕的情况:

1. 出现复数

记旋转矩阵$Q$为使矩阵中每个向量旋转90°的矩阵,二维即:

$$Q=\begin{bmatrix} \cos{90^{\circ}} & -\sin{90^{\circ}}\\ \sin{90^{\circ}} & \cos{90^{\circ}} \end{bmatrix} =\begin{bmatrix} 0 & -1 \\ 1 & 0 \end{bmatrix}$$

通过刚才可以知道:

$$ \begin{cases} \text{trace} = 0+0 = \lambda_{1} + \lambda_{2} \\ \det = 1 = \lambda_{1}\lambda_{2} \end{cases} $$

$\lambda_{1}$和$\lambda_{2}$没有实数解,有复数解:$\lambda_{1}=i$ 和 $\lambda_{2}=-i$

解释其实就是,对向量旋转90°,除非是零向量,否则不可能出现$Ax=\lambda x$中平行的情况

2. 出现重根

上三角矩阵: $A=\begin{bmatrix} 3 &1 \\ 0&3\end{bmatrix}$

顺带一提,上三角矩阵的特征值就是对角线上的元素

他的两个特征值都是: $\lambda_{1} = \lambda_{2} = 3$

所以这个矩阵的特征向量是:

$$ (A-\lambda I)x = \begin{bmatrix} 0 &1 \\ 0 &0 \end{bmatrix}x = 0 \rightarrow x_{1} = \begin{bmatrix} 1 \\ 0\end{bmatrix} $$

只有一个特征向量,没有第二个无关的特征向量

3.2.2 特征值性质

特征值的和等于矩阵$A=\left(a_{\mathrm{ij}}\right)_{n \times n}$的迹(trace): tr即对角线元素之和

$$\sum a_{i i}=\sum \lambda_{i}=\operatorname{tr}(A)$$

特征值的积等于矩阵$A$的行列式

$$\prod \lambda_{i}=\operatorname{det}(A)$$

矩阵和其转置矩阵的特征值一样

$$\operatorname{det}(A-\lambda I) = \operatorname{det}(A-\lambda I)^{T} = \operatorname{det}(A^{T}-\lambda I)$$

3.3 矩阵的对角化

特征向量矩阵$S$:将矩阵$A$的n个线性无关的特征向量按列组成的矩阵(即可逆)

特征值矩阵$\Lambda$:矩阵$A$的n个特征值构成的矩阵,特征值在矩阵的对角线上

$$A=S\Lambda S^{-1}$$

$$ \begin{aligned} AS & = A\begin{bmatrix} x_{1} &x_{2} & \cdots &x_{n}\end{bmatrix} \\ & = \begin{bmatrix}\lambda_{1}x_{1} &\lambda_{2}x_{2} &\cdots &\lambda_{n}x_{n}\end{bmatrix} \\ & = \begin{bmatrix} x_{1} &x_{2} & \cdots &x_{n}\end{bmatrix}\begin{bmatrix} \lambda_{1} &0 &\cdots &0 \\ 0 &\lambda_{2} &\cdots &0 \\ \vdots &\vdots &\ddots &\vdots \\ 0 &0 &\cdots &\lambda_{n} \end{bmatrix} \end{aligned} =S\Lambda $$

可以通过$Ax=\lambda x$来记$AS=S\Lambda$

$$S^{-1}AS = \Lambda$$

这样就可以实现矩阵的对角化,得到对角矩阵$\Lambda$

进行对角化的条件:

矩阵$A$没有重复的特征值(充分不必要)。如果存在重复的特征值,可能但不一定存在n个线性无关特征向量(比如n维的单位向量,特征值只有1,但是特征向量是每一列),只要没有重复的特征向量就行。

应用:求矩阵的幂

$$Ax = \lambda x \rightarrow A^{2}x = \lambda Ax = \lambda^{2}x$$

$$A^{2} = S\Lambda S^{-1}S\Lambda S^{-1} = S\Lambda^{2}S^{-1}$$

上面两个式子说明了同一件事:$A^{2}$的特征值是$A$的平方,$A$的特征向量和$A^{2}$一样,对角化提供了一种以矩阵形式思考的解决方法。

同理,可拓展到$K$次幂:

$$A^{k} = S\Lambda^{k}S^{-1}$$

3.4 特征值应用

3.4.1 差分方程

$$ \begin{cases} \text{初始向量 } u_{0} \\ \text{差分方程 } u_{k+1} = Au_{k} \end{cases} $$

$$u_{k} = A^{k}u_{0}$$

其中,初始矩阵$u_{0}$可以写成$A$的特征向量的线性组合形式 (因为特征向量之间线性无关,$A$非奇异不会产生重复的特征向量看,所以特征向量矩阵的列空间铺满了整个空间)

$$u_{0} = c_{1}x_{1} + c_{2}x_{2} + \cdots + c_{n}x_{n}$$

$$Au_{0} = c_{1}\lambda_{1} x_{1} + c_{2}\lambda_{2}x_{2} + \cdots + c_{n}\lambda_{n}x_{n}$$

$$A^{100}u_{0} = c_{1}\lambda_{1}^{100} x_{1} + c_{2}\lambda_{2}^{100}x_{2} + \cdots + c_{n}\lambda_{n}^{100}x_{n}$$

举个例子:斐波那契数列

$$F_{k+2}=F_{k+1}+F_{k}\qquad [0, 1, 1, 2, 3, 5, 8, 13, 21, …]$$

定义向量:$u_{k}=\begin{bmatrix}F_{k+1}\\F_{k}\end{bmatrix}\therefore\left\{\begin{aligned} &F_{k+2} = F_{k+1} + F_{k} \\ &F_{k+1} = F_{k+1} \end{aligned}\right.\Rightarrow u_{k+1}=Au_{k};A=\begin{bmatrix} 1 &1 \ 1 &0 \end{bmatrix}$

A的特征值:$\lambda=\frac{1\pm \sqrt{5}}{2}$

因为斐波那契数列是增长的,所以增长速度应该是 $\lambda_{1}=\frac{1+\sqrt{5}}{2}$

从$u_{0}=\begin{bmatrix}F_{1}\\F_{0}\end{bmatrix}=\begin{bmatrix}1\\0\end{bmatrix}=c_{1}x_{1}+c_{2}x_{2}$ 可以求得 $c_{1}=\frac{1}{\sqrt{5}}$,$c_{2}=-\frac{1}{\sqrt{5}}$

所以,$\begin{bmatrix}F_{100}\\F_{99}\end{bmatrix}=A^{99}\begin{bmatrix}F_{1}\\F_{0}\end{bmatrix}$,$F_{100}=c_{1}\lambda_{1}^{100}+c_{2}\lambda_{2}^{100}$

所以,$F_{100}\approx c_{1}\lambda_{1}^{100}$

3.4.2 微分方程

3.4.3 马尔科夫矩阵

马尔科夫矩阵,满足两条性质:1. 每个元素大于等于0; 2. 每一列相加都等于0 (与概率有着非常紧密的联系)

假设使用马尔科夫矩连续乘以一个正的向量$u_{0}$,即

$$u_{1} = Au_{0}; \qquad u_{2} = Au_{1}; \quad \cdots;\quad u_{n} = Au_{n-1}$$

k步之后我们可以得到$A^{k}u$,这些向量会最终接近一个稳定状态,比如:

$$A=\begin{bmatrix} .8 & .3 \\ .2 & .7\end{bmatrix}$$

对于每一个$u_{0}=(a,1-a)$,都可以收敛到稳定的状态:$u_{\infty}=(0.6,0.4)$

现在来讨论能到达稳态的条件:

- $\lambda=1$是马尔科夫矩阵$A$的特征值

- 马尔科夫矩阵$A$的其他特征值都绝对值小于1,即 $|\lambda|<1$

在遇到矩阵连乘时,根据特征值分解,我们可以得到:

$$u_{k} = A^{k}u_{0} = u_{0}(c_{1}\lambda_{1}^{k} x_{1} + c_{2}\lambda_{2}^{k}x_{2} + \cdots + c_{n}\lambda_{n}^{k}x_{n})$$

所以,要想$u_{\infty}$到达稳态,必须有一个特征值为1,其他特征值项逐渐消失才行

现在要判断马尔科夫矩阵一定有一个特征值等于一,所以判断$A-I$是不是奇异的:

当$A-I$所有列相加得到0,就说明$A-I$是奇异的

因为马尔科夫矩阵每一列和为1,所以$A-I$每一列和为0,所以用行向量$(1,1,1)$左乘$A-I$可以得到0,即$(0,0,0)A=0$,说明(1,1,1)在$A-I$的左零空间中,行向量线性相关,矩阵是奇异的

这里其实就拓展出来好多,因为对于行列式来说行列是无关的$\det(A)=\det(A^{T})$,而只要 $\det=0$ 矩阵就奇异,所以只要零空间/左零空间有非0向量,那么这个矩阵就是奇异的

还有特征值的一个性质:矩阵和其转置的特征值是一样的

证明:$\det(A-\lambda I)=0 \rightarrow \det(A^{T}-\lambda I)=0$

3.4.4 傅里叶级数

讨论一下带有标准正交基的投影问题

给定标准正交基 $q_{1},\cdots,q_{n}$,任意向量可以以标准正交基的一个组合进行表达:

$$v=x_{1}q_{1}+x_{2}q_{2}+\cdots+x_{n}q_{n}$$

现在想要知道,对于$v$,标准正交基的组合数$x_{1},x_{2},\cdots,x_{n}$是多少

那么标准正交基在这里就非常有用了,例如想求$x_{1}$,则左右两边都对$q_{1}$做内积,因为是正交的,所以除了$x_{1}$这一项,其他都是0

$$q^{T}_{1}v=x_{1}q^{T}_{1}q_{1}+0+\cdots+0$$

因为是标准正交基,所以$q^{T}_{1}q_{1}=1$,即$x_{1}=q^{T}_{1}v$

使用矩阵形式可以得知:

$$v=Qx,\qquad Q=\begin{bmatrix} q_{1} &q_{2} &\cdots &q_{n} \end{bmatrix},\qquad x=\begin{bmatrix} x_{1} \\ \vdots \\ x_{n} \end{bmatrix}$$

可得:$x = Q^{-1}v$,因为$Q$是标准正交矩阵,所以$x=Q^{T}v$

现在代入傅里叶级数

已知函数$f(x)$,我们想把它写成组合的形式,包含常数项,也包含$\cos$,$\sin$项等,即:

$$f(x) = a_{0} + a_{1}\cos{x}+b_{1}\sin{x}+a_{2}\cos{2x}+b_{2}\sin{2x}+\cdots$$

这个就是傅里叶级数,无穷维,并且$\cos$和$\sin$还正交,它作用在函数空间上,可以用函数$f(x)$来代替$v$,可以使用正交函数$\cos,\sin,\cdots$来代替正交向量$q_{1},q_{2},\cdots$

函数的正交类比于向量的正交:

向量的正交:两个向量的点积为0,即 $v^{T}w=v_{1}w_{1}+\cdots+v_{n}w_{n}$

函数的正交:给定两个函数,记为$f$和$g$,类比于向量的正交取点积,即对于取值积$f(x)g(x)$的和为0,即 $f^{T}g=\int{f(x)g(x)}\mathrm{d}x$

现在我们关心如何求$a_{0},a_{1},\cdots$,以$a_{1}$为例,同刚才投影一样,两边对$\cos{x}$进行正交

$$\int_{0}^{2\pi}{f(x)\cos{x}\mathrm{d}x}=a_{1}\int^{2\pi}{0}(\cos{x})^{2}=\pi a{1}$$

3.5 矩阵的相似性

相似矩阵:$A$和$B$是$n\times n$相似矩阵,意味着存在一个可逆矩阵$M$使得:$B=M^{-1}AM$

举个例子:特征值分解 $S^{-1}AS = \Lambda$,即$A$和$\Lambda$是相似的

相似矩阵的共同点: 他们具有相同的特征值,无关特征向量的数目也一样

讨论存在相等特征值情况下的相似性:

例如两个特征值相等为4: $\lambda_{1}=\lambda_{2}=4$,可以分别是如下两种矩阵:

$$ \begin{bmatrix} 4 &0 \\ 0&4\end{bmatrix},\quad \begin{bmatrix} 4 &1 \\ 0&4\end{bmatrix} $$

但是这两个矩阵不是相似的

$\begin{bmatrix} 4 &0 \\ 0&4\end{bmatrix}$只和自己相似,$M^{-1}4IM=4I$,

$\begin{bmatrix} 4 &1 \\ 0&4\end{bmatrix}$可以代表一个大家族,称为若尔当标准型,即最简单,最接近对角阵的一个(但他不能对角化,如果能的话,他就和上面的这个矩阵相似了)

再举一个特例:

$$\begin{bmatrix} 0 &1 &0 &0 \\ 0 &0 &1 &0 \\ 0 &0 &0 &0 \\ 0 &0 &0 &0\end{bmatrix},\quad\begin{bmatrix} 0 &1 &0 &0 \\ 0 &0 &0 &0 \\ 0 &0 &0 &1 \\ 0 &0 &0 &0\end{bmatrix}$$

这两个矩阵的特征值$\lambda_{1}=\lambda_{2}=\lambda_{3}=\lambda_{4}=0$,但是很明显他们不是相似的

若尔当解释他们的分块是不一样的,第一个矩阵的分块是$\begin{bmatrix} 0 &1 &0 \\ 0 &0 &1 \\ 0 &0 &0\end{bmatrix}$和$[0]$,第二个矩阵的分块是$\begin{bmatrix} 0 &1 \\ 0 &0\end{bmatrix}$ 和$\begin{bmatrix} 0 &1 \\ 0 &0\end{bmatrix}$,所以他们是不相似的

若尔当定理: 每个方阵$A$都相似于一个若尔当阵$J$,若尔当阵即由若干个若尔当块都成的矩阵:

$$J=\begin{bmatrix} J_{1} &&& \\ &J_{2} && \\ &&\ddots& \\ &&&J_{d} \end{bmatrix}$$

若尔当块:特征值位于方阵的对角线上,若尔当块的数量等于特征向量的数量

3.6 奇异值分解 (SVD)

矩阵最终和最好的分解:任何矩阵都可以有奇异值分解,中间是一个对角矩阵,两边是两个正交矩阵

$$A=U\Sigma V^{T}$$

- $\Sigma$是对角矩阵

- $U$ 和 $V$ 都是正交矩阵

3.6.1 Motivation:标准正正交基的变换

行空间 $\in\mathbb{R}^{n}$ 中的标准正交基$v_{1},v_{2},\cdots$,寻找一个变换$A_{m\times n}$,使之变换成列空间 $\in\mathbb{R}^{m}$ 中的一组正交基$u_{1}=Av_{1},u_{2}=Av_{2},\cdots$,即

$$Av_{1} = \sigma_{1}u_{1} \\Av_{2} = \sigma_{2}u_{2}\\ \cdots$$

其中,$\sigma$是伸缩向量,目的是为了是使得$v$也是归一化后的标准正交基

化成矩阵形式即:

$$ A\begin{bmatrix} v_{1} &v_{2} &\cdots &v_{r} \end{bmatrix} = \begin{bmatrix} u_{1} &u_{2} &\cdots \end{bmatrix} \begin{bmatrix} \sigma_{1} && \\ &\sigma_{2} & \\ &&\ddots \end{bmatrix} $$

即

$$AV = U\Sigma$$

$$A = U\Sigma V^{-1}$$

$$AV = U\Sigma V^{T}$$

$V$ 是标准正交的

3.6.2 SVD分解

举个例子,对于矩阵$A=\begin{bmatrix} 4 &4 \\ -3 &3 \end{bmatrix}$

- 要寻找行空间中的$v_{1},v_{2} \in \mathbb{R}^{2}$

- 要寻找空间中的$v_{1},v_{2} \in \mathbb{R}^{2}$

- 找出归一化系数$\sigma_{1}>0, \sigma_{2}>0$

同时求 $U$ 和 $V$ 太困难了,所以我们想办法消去$U$,先求 $V$

$$ \begin{aligned} A^{T}A &= V\Sigma^{T}U^{T}U\Sigma V^{T} \\\\ &= V\Sigma^{T}\Sigma V^{T} \\\\ &= V\begin{bmatrix} \sigma_{1}^{2} && \\ &\sigma_{2}^{2}& \\ &&\ddots \end{bmatrix} V^{T} \end{aligned} $$

这里最后化简成了对称矩阵$A^{T}A$的对角化形式(特征值分解)$Q\Sigma Q^{T}$,其中$\begin{bmatrix} \sigma_{1}^{2} && \\ &\sigma_{2}^{2}& \\ &&\ddots \end{bmatrix}$是$A^{T}A$的特征值矩阵,$V$是$A^{T}A$的特征向量矩阵

所以如何求 $V$ 、$U$ 和 $\Sigma$:

- $A^{T}A$的特征值向量就是$V$

$AA^{T}$的特征值向量就是$U$- $A^{T}A$的特征值就是$\sigma$的平方

这里需要注意的是,通过上述我们无法确定特征向量的符号,在求出$V$后,只能根据$V$的符号来对应$U$的符号,即$Av_{i}=\sigma_{i}u_{i}$

下面来针对上面的矩阵$A=\begin{bmatrix} 4 &4 \\ -3 &3 \end{bmatrix}$实践一下

$$ A^{T}A = \begin{bmatrix} 4 &-3 \\ 4 &3 \end{bmatrix} \begin{bmatrix} 4 &4 \\ -3 &3 \end{bmatrix}= \begin{bmatrix} 25 &7 \\ 7 &25\end{bmatrix} $$

标准化后的特征向量是

$$\begin{bmatrix} \frac{1}{\sqrt{2}} \\ \frac{1}{\sqrt{2}}\end{bmatrix};\quad \begin{bmatrix} \frac{1}{\sqrt{2}} \\ -\frac{1}{\sqrt{2}}\end{bmatrix}$$

得到的特征值是:

$$\lambda_{1} = 32; \quad \lambda_{2} = 18$$

所以可以得到SVD分解中的 $\Sigma$ 和 $V$:

$$ \Sigma = \begin{bmatrix} \sqrt{32} &0 \\ 0 &\sqrt{18}\end{bmatrix};\qquad V=\begin{bmatrix} \frac{1}{\sqrt{2}} & \frac{1}{\sqrt{2}} \\ \frac{1}{\sqrt{2}} & -\frac{1}{\sqrt{2}} \\ \end{bmatrix} $$

下面用相同的方法去求$U$

$$ AA^{T} = \begin{bmatrix} 4 &4 \\ -3 &3 \end{bmatrix}\begin{bmatrix} 4 &-3 \\ 4 &3 \end{bmatrix} = \begin{bmatrix} 32 &0 \\ 0 &28 \end{bmatrix} $$

标准化后的特征向量:

$$\begin{bmatrix} 1 \\ 0 \end{bmatrix};\quad\begin{bmatrix} 0 \\ 1 \end{bmatrix}$$

得到 $U=\begin{bmatrix} 1 &0 \\ 0&1 \end{bmatrix}$

但是这个$U$是不对的

$AV=\Sigma U$验算不回去,因为同样是特征向量,符号是可以不确定的,而这里选择正的特征向量刚刚好是错误的,所以在指定$V$的特征向量后,对应的$Av_{i}=\sigma_{i}u_{i}$的特征向量符号就出来了

所以这里计算$U$,应该使用$Av_{i}=\sigma_{i}u_{i}$,即:

$$ Av_{1} = \begin{bmatrix} 4 &4 \\ -3 &3 \end{bmatrix} \begin{bmatrix} \frac{1}{\sqrt{2}} \\ \frac{1}{\sqrt{2}}\end{bmatrix} = \begin{bmatrix} 4\sqrt{2}\\ 0 \end{bmatrix} =\sigma_{1}u_{1}=\sqrt{32}u_{1} $$

$$ Av_{2} = \begin{bmatrix} 4 &4 \\ -3 &3 \end{bmatrix} \begin{bmatrix} \frac{1}{\sqrt{2}} \\ -\frac{1}{\sqrt{2}}\end{bmatrix} = \begin{bmatrix} 0 \\ -3\sqrt{2} \end{bmatrix} =\sigma_{2}u_{2}=\sqrt{18}u_{1} $$

$$ u_{1} = \begin{bmatrix} 1 \\ 0 \end{bmatrix};\qquad u_{2} = \begin{bmatrix} 0 \\ -1 \end{bmatrix};\qquad U=\begin{bmatrix} 1 &0 \\ 0&-1 \end{bmatrix} $$

和上面的错误结果只有符号的差异

A. 矩阵计算

A.1 乘法

A.1.1 向量与向量的点积

向量$a=[a_{1},a_{2},\cdots]$与向量$b=[b_{1},b_{2},\cdots]$的点积(内积)为:

$$a·b =a_{1}b_{1}+\cdots+a_{n}b_{n} = \sum{a_{i}b_{i}}$$

点积是一个数,而下面这种变换是一个矩阵,类似点积的矩阵

$$ \begin{aligned} &{\left[\begin{array}{llll} a_{1} b_{1} & a_{2} b_{2} & \cdots & a_{n} b_{n} \end{array}\right]} \\ =&{\left[\begin{array}{llll} b_{1} & b_{2} & \cdots & b_{n} \end{array}\right]\left[\begin{array}{cccc} a_{1} & 0 & \cdots & 0 \\ 0 & a_{2} & \cdots & 0 \\ \vdots & \vdots & \ddots & \vdots \\ 0 & 0 & \cdots & a_{n} \end{array}\right]} \end{aligned} $$

A.1.2 向量与矩阵相乘

左行右列,左乘行变换,右乘列变换

列向量是乘在矩阵的右边,对矩阵的每一列进行线性合并,得到的是列向量

$$ \begin{bmatrix} 2 &5 \\ 1 & 3 \end{bmatrix} \begin{bmatrix} 1\\2 \end{bmatrix} = 1 \times \begin{bmatrix} 2\\ 1 \end{bmatrix} + 2 \times \begin{bmatrix} 5\\ 3 \end{bmatrix} =\begin{bmatrix} 12\\ 7 \end{bmatrix} $$行向量是乘在矩阵的左边,对矩阵的每一行进行线性合并,得到的是行向量

$$ \begin{bmatrix} 1 &2 &7 \end{bmatrix} \begin{bmatrix} 2 & 3 & 4 \\ 1 & 3 & 4 \\ 2 & 3 & 5 \end{bmatrix} = \begin{bmatrix}2 &3 &4\end{bmatrix}\times 1 + … + \begin{bmatrix}2 &3 &5\end{bmatrix}\times 7 = \begin{bmatrix}18 &30 &47\end{bmatrix} $$

使用列向量进行思考非常重要

A.1.3 矩阵与矩阵相乘

$$AB=C$$

用一下几种方法来思考矩阵相乘:

点乘法

其中矩阵$C$的3行4列的元素$C_{34}=A_{row-3}\cdot B_{col-4}=\sum_{k=1}^{n}{a_{3k}b_{k4}}$

列向量法

$$A_{m\times n}B_{n\times p} = C_{m\times p}$$

可以将乘法考虑成一个矩阵右乘以一个列向量,得到一个列向量。也就是矩阵A右乘矩阵B中的每一个列向量。那么,矩阵C的各列是矩阵A中各列的线性组合

行向量法

与列向量法类似,可以将乘法考虑成矩阵B左乘矩阵A中的行向量,

矩阵C的各行是矩阵B中各行的线性组合

列$\times$行

常规方法中,是A的行$\times$B的列,得到是相对应位置的标量

但是这里可以是A的列$\times$B的行。$AB$是A的各列$\times$B的各行的矩阵的和

分块乘法

将矩阵进行分块,对每一个分块进行乘法

$$ \begin{bmatrix} A_{1} & A_{2} \\ A_{3} & A_{4} \end{bmatrix} \begin{bmatrix} B_{1} & B_{2} \\ B_{3} & B_{4} \end{bmatrix} = \begin{bmatrix} A_{1}B_{1} + A_{2}B_{3} & A_{1}B_{2}+A_{2}B_{4} \\ A_{3}B_{1} + A_{4}B_{3} & A_{3}B_{2}+A+{4}B_{4} \end{bmatrix} $$

A.2 逆 (Inverse)

含义:消去原矩阵的影响;只考虑方阵

(把矩阵可以想象成一个函数,$A^{-1}A=I$,$A^{-1}$消去了$A$的影响)

A.2.1 存在逆

如果存在,可以成立:$A^{-1}A=I$,$I$为单位阵。其中,这里的是左逆,也可以有右逆,表达为:$AA^{-1}=I$

对于方阵,左逆=右逆,即$A^{-1}A=I=AA^{-1}$

如果逆存在,那么矩阵A是可逆的,也就是非奇异的(non-singular)

求逆:对增广矩阵($[AI]$)进行消元,得到$E[A|I]=[EA|EI]=[I|E]$,那么$E$就是$A^{-1}$

$$ \begin{bmatrix} \begin{array}{cc|cc} 1 & 3 & 1 & 0 \\ 2 &7 & 0 & 1 \end{array} \end{bmatrix} \rightarrow \begin{bmatrix} \begin{array}{cc|cc} 1 & 3 & 1 & 0 \\ 0 &1 & -2 & 1 \end{array} \end{bmatrix} \rightarrow \begin{bmatrix} \begin{array}{cc|cc} 1 & 0 & 7 & -3 \\ 0 &1 & -2 & 1 \end{array} \end{bmatrix} $$

另一种办法是通过行列式来计算,提供了一种代数的表达

性质:

- 转置和逆可互换操作:$(A^{-1})^{T} = (A^{T})^{-1}$

- 矩阵乘积的逆:$(A B)^{-1}=B^{-1} A^{-1}$

A.2.2 不存在逆,奇异矩阵

如果存在非0向量$x$使得$Ax=0$,那么这个矩阵$A$是奇异的(singular)

也就是其实在矩阵A中的列向量,最少有一对向量是共平面的

A.3 转置 (Transpose)

$$(A^{T})_{ij}=A_{ji}$$

A.4 线性变换

线性变换:加法和数乘,线性变换应该保证这两种运算的不变形,即:

$$ \begin{aligned} T(v+w) &= T(v) + T(w) \\\\ T(cv) &= cT(v) \end{aligned} $$

等同于判断:

$$T(cv+dw) = cT(v) + dT(w)$$

举个例子:投影就是线性变换

A.4.1 坐标

坐标:源自于一组基,$v$的坐标是一组数字:$c_{1},c_{2},\cdots$,表示了$v$由多少个基向量组成,即$v=c_{1}v_{1}+c_{2}v_{2}+\cdots$

平时的话是因为默认存在了标准正交基,即$v=\begin{bmatrix} 3 \\ 2 \\ 4\end{bmatrix}$,但是里面的含义其实是:

$$ v = 3\begin{bmatrix}1 \\ 0 \\ 0\end{bmatrix} + 2\begin{bmatrix}1 \\ 1 \\ 0\end{bmatrix} + 4\begin{bmatrix}1 \\ 0 \\ 1\end{bmatrix} $$

B. 特殊矩阵

B.1 增广矩阵

B.2 消元矩阵

B.3 初等矩阵 (E)

B.4 置换矩阵 (P)

对行进行调换:

$$ \begin{bmatrix} 0 &1 \\ 1 &0 \end{bmatrix} \begin{bmatrix} a &b \\ c &d \end{bmatrix} = \begin{bmatrix} c &d \\ a &b \end{bmatrix} $$

其中,$P=\begin{bmatrix} 0 &1 \\ 1 &0\end{bmatrix}$就是置换矩阵 (Permutation),将两行进行位置的调换

同理,如果想对列进行置换,那么需要将矩阵进行右乘,左行右列

可以看到,因为想要消除置换矩阵带来的影响,那就是把它再置换回去,那么置换矩阵的逆就是置换矩阵的转置

$$P^{-1}=P^{T}$$

分清转置(T,是一个操作) 和 置换(P,是一个矩阵),两个不一样的东西

对于$n$维方阵,共有$n!$个置换矩阵。(相当于$n$个列向量的排列)

B.5 奇异矩阵

B.6 对称矩阵 (S)

非常重要的矩阵!有非常好的性质

对称矩阵 (symmetric):转置变换以后没有变化的矩阵,$A^{T}=A$

特征值是实数

特征向量是垂直的(正交)

对称矩阵的特征值分解称为谱定理

$$A=S\Lambda S^{-1} \rightarrow A=Q\Lambda Q^{-1}=Q\Lambda Q^{T}$$

谱:特征值的结合

主元与特征值的符号个数一致 (正主元的个数 = 正特征值的个数)

一个特殊的对阵矩阵:$A^{T}A$,其中$A_{m\times n}$是任意矩阵

- $A^{T}A$ 是 $n\times n$ 的方阵

- $A^{T}A$ 是对称矩阵

- $A^{T}A$ 是正定的

- $N(A^{T}A) = N(A)$, $\text{rank}(A^{T}A)=\text{rank}(A)$,所以$A^{T}A$可逆当且仅当$A$的各列线性无关,零空间只有一个零向量

应用:最小二乘 (E)

B.7 正定矩阵

正定矩阵(postive definite matrix):所有特征值为正数的对称矩阵

对于正定矩阵的几种判定方法,以$A=\begin{bmatrix} a &b \\ c &d\end{bmatrix}$为例:

- 所有的特征值为正:$\lambda_{1}>0, \lambda_{2}>0$

- 所有主子矩阵(即西雅图子矩阵,Seattle submatrices)的行列式都是正的:$a>0, ac-b^{2}>0$

- 所有的主元都是正的: $a>0, \frac{ac-b^{2}}{a}>0$

- $x^{T}Ax>0$

- 正定矩阵的逆也是正定的,因为特征值是原矩阵特征值的倒数,所以都是正的

- 矩阵$A, B$都是正定的, $A+B$也是正定的,因为$x^{T}(A+B)x>0$

- 对于长方矩阵$S_{m\times n}$,$S^{T}S$是正定的,$x^{T}A^{T}Ax=(Ax)^{T}Ax$,等于$Ax$的长度的平方$\ge 0$

正定可以检查函数是否存在最小值

B.8 最简行阶梯型矩阵 (R)

B.9 投影矩阵 (P)

B.10 正交矩阵 (Q)

B.11 特征向量矩阵 (S)

B.12 旋转矩阵 (R)

旋转矩阵(Rotation matrix):是在乘以一个向量的时候有改变向量的方向但不改变大小的效果并保持了手性的矩阵。

二维情况:

$$ \begin{aligned} M(\theta)&=\left[\begin{array}{cc} \cos \theta & -\sin \theta \\ \sin \theta & \cos \theta \end{array}\right] \\\\ &=\cos \theta\left[\begin{array}{cc} 1 & 0 \\ 0 & 1 \end{array}\right]+\sin \theta\left[\begin{array}{cc} 0 & -1 \\ 1 & 0 \end{array}\right] \\\\ &=\exp \left(\theta\left[\begin{array}{cc} 0 & -1 \\ 1 & 0 \end{array}\right]\right) \end{aligned} $$

C. 向量空间

“向量组”是线性相关、无关;“向量组”生成一个空间;“向量组”作为一组基

他们都是针对的向量组进行讨论,而不是矩阵

空间:: 设向量组$v_{1},v_{2},\cdots,v_{l}$生成(span)了一个向量空间,表示这个空间包含了这些向量的所有线性组合(即对加法和数乘封闭)。比如: $\mathbb{R}^{2}$,表示所有的二维实向量。

$$ \begin{bmatrix} 3 \\ 2 \end{bmatrix}, \begin{bmatrix} 0 \\ 0 \end{bmatrix}, \begin{bmatrix} \pi \\ e \end{bmatrix}, \cdots $$

$\mathbb{R}^{n}$ 包含所有的n维实向量

子空间:需要满足线性运算,但同时又是空间的子集,比如$\mathbb{R}^{2}$的子空间:1. $\mathbb{R}^{2}$本身; 2. 所有经过原点的直线; 3. (0,0)点

C.1 基

向量空间的基:指一系列的向量$v_{1},v_{2},\cdots,v_{d}$,他们线性无关、可以生成整个向量空间

C.2 维度

维度:向量空间中基的个数。(可以表征空间的大小)

对于给定空间,$\mathbb{R}^{2},\mathbb{R}^{n},…$,空间中基的个数是相等的,即维数是相等的

$$ A=\begin{bmatrix} 1 &2 &3 &1 \\ 1 &1 &2 &1 \\ 1 &2 &3 &1 \end{bmatrix} $$

他的列空间$C(A)$,前两列向量就是这个列空间的基,那么这个列空间的维数就是矩阵$A$的秩。( 注意,这里说的不是矩阵$A$的维度,而是矩阵$A$的列空间的维度! )

零空间表达是这些向量组怎么线性相关的,零空间的维度是$dim N(A) = n-r$

C.3 线性相关

如果不存在结果为零向量的组合,则向量组线性无关(除非系数全0)

当向量$x_{1}, x_{2}, \cdots, x_{n}$是矩阵$A$的列向量,如果矩阵$A$的零空间只存在零空间,那么这个向量组线性无关,即这个矩阵$A$的秩$r=n$

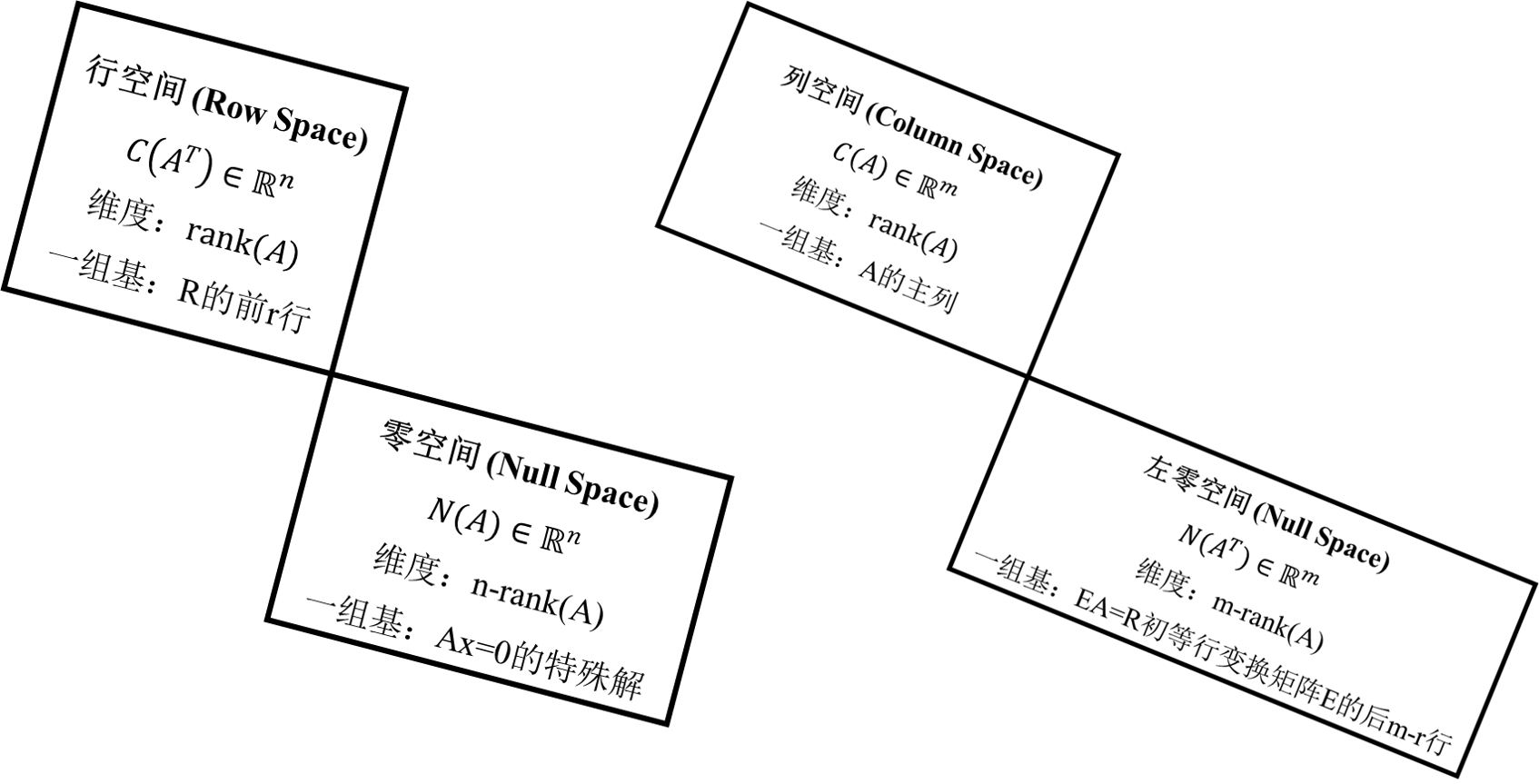

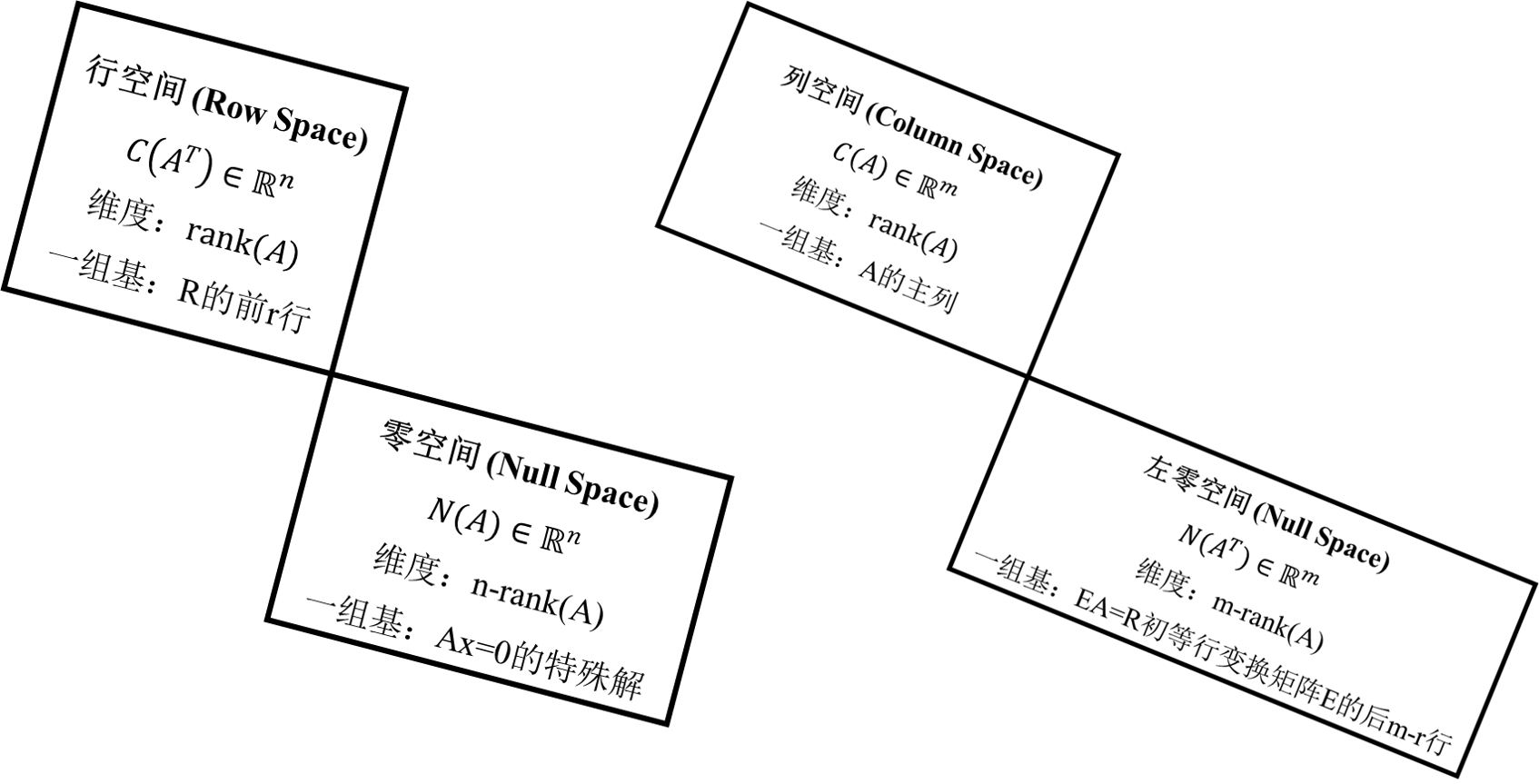

C.4 四个基本子空间

| 子空间 | 维度 | 一组基 |

|---|---|---|

| 列空间 | 矩阵$A$的秩$rank(A)$ | 矩阵$A$的$r$个主列 (注意这里是矩阵$A$,不是$U$或是$R$) |

| 行空间 | 矩阵$A$的秩$rank(A)$ | 行最简矩阵$R$的前$r$行 |

| 零空间 | $n-r$ | $Ax=0$得到的特殊解 (每个自由变量都可以得到一个特殊解) |

| 左零空间 | $m-r$ | 对$A$进行初等行变换到$R$的矩阵$E$的最后$m-r$行 |

C.4.1 列空间

$$ A=\begin{bmatrix} 1 &1 &2 \\ 2 &1 &3 \\ 3 &1 &4 \\ 4 &1 &5 \\ \end{bmatrix} $$

矩阵$A$的列看做向量,他的列的所有线性组合都成一个子空间,称为列空间,记作$C(A)$。那么矩阵$A$的列空间是$\mathbb{R}^{4}$的子空间,

$C(A)$由这三个列向量线性组合的所有向量构成,因为矩阵A的三个列向量不是线性无关的,所以$C(A)$是$\mathbb{R}^{4}$中的二维子空间

C.4.2 零空间

$A$的零空间包含$Ax=0$中所有的解$x=\begin{bmatrix} x_{1} \\ x_{2} \\ x_{3}\end{bmatrix}$,对于矩阵$A$,他的零空间属于$\mathbb{R}^{3}$

$Ax=0$的特解:

$$ \begin{bmatrix} 0 \\ 0 \\ 0 \end{bmatrix}, \begin{bmatrix} 1 \\ 1 \\ -1 \end{bmatrix} $$

所以A的零空间包含了$c\begin{bmatrix} 1 \\ 1 \\ -1\end{bmatrix}$

所以A的零空间就是$\mathbb{R}^{3}$中的一条直线

C.4.3 行空间

$$A=\begin{bmatrix} 1 &2 &3 &1 \\ 1 &1 &2 &1 \\ 1 &2 &3 &1\end{bmatrix} \rightarrow \begin{bmatrix} 1 &0 & 1 &1 \\ 0 &1 &1 &0 \\ 0 &0 &0 &0\end{bmatrix}$$

因为在化成最简行阶梯形式$R$的过程中经历了行变化,此时$C(A)!= C(R)$,但是他们的行空间却是相等的,所以行空间的一组基就是最简行阶梯形式$R$的前r行

C.4.4 左零空间

$A^{T}y=0$,$y$就在$A$转置矩阵的零空间中

对两边进行转置,可得:$y^{T}A=0$,这个时候$y_{T}$对$A$进行左乘,所以得名左零空间,记作$N(A^{T})$

使用高斯-若当法(就是之前求逆的那个方法),来求左零空间

$$ E\begin{bmatrix} A_{m\times n}| I_{m\times m}\end{bmatrix} \rightarrow \begin{bmatrix} R_{m\times n} | E_{m\times m}\end{bmatrix} $$

因为最简行阶梯矩阵$R$的形式是酱紫的:

$$E_{m\times m}A_{m\times n}=R_{m\times n}=\begin{bmatrix} \colorbox{yellow}{I} \colorbox{pink}{F} \\ \colorbox{orange}{0\quad 0} \end{bmatrix}$$

$R$的下面$m-r$行都是0,所以对应于$E_{m\times m}$的最后$m-r$行就是左零空间的基

左乘是行变换(左行右列),$E_{m\times m}$最后几行,左乘$A$得到的行都是0,所以是左零空间的基

C.5 矩阵空间

把矩阵当做向量,满足加法和数乘

这里讨论所有的3x3矩阵组成的空间$M$。他的一组基是:

$$ \begin{bmatrix} 1 &0 &0 \\ 0 &0 &0 \\ 0 &0 &0 \end{bmatrix} \begin{bmatrix} 0 &1 &0 \\ 0 &0 &0 \\ 0 &0 &0 \end{bmatrix} \cdots \begin{bmatrix} 0 &0 &0 \\ 0 &0 &0 \\ 0 &0 &1 \end{bmatrix} $$

所以$M$的维度是9,(维度的定义即需要至少九组线性无关的基来生成整个空间)

$M$的子空间:所有的上三角矩阵、对称矩阵、对角矩阵,….

| 维度 | ||

|---|---|---|

| 对称矩阵$S$ | 6 | 对称矩阵不是对角矩阵 |

| 上三角矩阵$U$ | 6 | |

| 对角矩阵$D$ | 3 |